Trois éléments sont directement responsables de la qualité technique d’une image numérique. S’il y a bien sur sur la qualité de l’optique et du capteur, il ne faut pas oublier le processus d’interprétation des données transmises par le capteur. C’est cette opération que l’on appelle le dématriçage et qui intervient dans le processus d’obtention de l’image finale. Qu’est ce qui se passe pendant cette opération ? En quoi cette opération est elle si importante ? C’est ce que je vous propose de voir aujourd’hui…

Le capteur et les photosites

Commençons par le commencement… Le capteur est conçu pour capter. Capter quoi ? les photons qui composent la lumière et qui lui parviennent via l’objectif.

Comment se passe cette opération ?

Ce qu’il faut comprendre c’est que le capteur est parsemé de petits trous, des puits à lumière. Ces trous, c’est ce que l’on appelle les photosites. Chaque photosite donnera naissance à un pixel sur l’image finale. Cela veut donc dire que si le capteur de votre APN délivre des images de 24 millions de pixels, il a donc 24 millions de photosites (dur hein ? 🙂 ).

La couleur d’un pixel est déterminée par la combinaison de trois valeurs : une première pour le rouge, une seconde pour le vert et une troisième pour le bleu. On appelle cela la synthèse additive RVB.

Le rôle du photosite est donc de compter, de mesurer la proportion de photons rouges, verts et bleus contenus dans la lumière qui lui parvient.

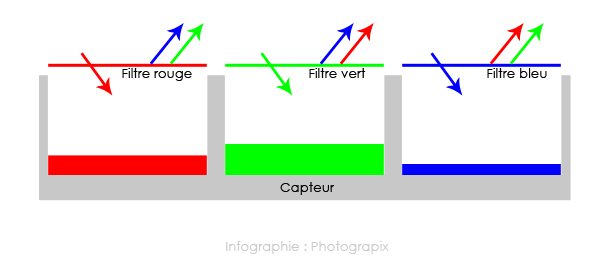

Malheureusement les photosites ne sont pas capables de percevoir la couleur. Seule solution : réserver certains photosites à la captation des photons rouges, d’autres aux verts et d’autres aux bleus.

Pour permettre cette captation séparée, un filtre coloré est positionné par dessus chaque photosite.

- certains photosites ont donc un filtre qui ne laisse passer que la longueur d’onde du rouge pour les photons rouges,

- d’autres ont un filtre qui ne laisse passer que la longueur d’onde correspondant au vert,

- d’autres enfin ont un filtre qui ne laisse passer que la longueur d’onde correspondant au bleu.

La matrice de filtres colorés

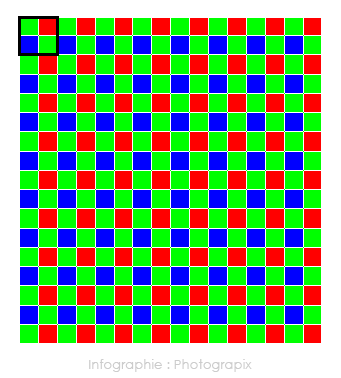

L’agencement de ces millions de petits filtres disposés côte à côte, par dessus les photosites, abouti à ce que l’on appelle une matrice de filtres.

Comme vous pouvez le constater sur l’illustration ci dessus, il y a deux fois plus de filtres qui laissent passer le vert que les deux autres couleurs. Pourquoi cette différence de proportion ? Tout simplement parce que notre oeil est quasiment deux fois plus sensible à la longueur d’onde du vert qu’à celle du rouge et au bleu.

Cette matrice de filtres colorés est la plus répandue. Elle équipe l’immense majorité des capteurs intégrés dans nos APN. On l’appelle matrice de Bayer du nom de l’ingénieur de chez Kodak qu’il l’a inventé (bon sang, quand on pense à ce qu’il est advenu de cette société alors que c’est elle qui a inventé l’appareil photo numérique…).

Fuji à fait un choix technologique différent en équipant une partie des capteurs de ses appareils d’un autre type de matrice : la x-trans ou les filtres ne sont pas disposés de la même manière que sur la matrice de Bayer. Cette matrice, de par l’agencement moins répétitif de ces filtres (par rapport à celle de Bayer), permet de ne pas générer d’effet de moirage (vous savez ces petits pixels magenta et verts qui peuvent apparaître lorsque la scène photographiée comporte des motifs répétitifs).

La matrice X Trans de Fuji

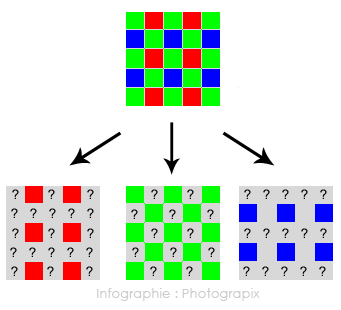

Malheureusement, l’ensemble de ces matrices souffrent d’un défaut: du fait que les filtres ne permettent pas à la 1/2 des photons verts et aux 3/4 des des photons rouges et bleus d’être captés par les photosites, comment faire pour connaître les deux valeurs manquantes permettant de déterminer la couleur pour chaque pixel ?

Seule solution : calculer, déduire ces deux valeurs manquantes. C’est cette opération que l’on appelle le dématriçage…

Le dématriçage

Comme on dit souvent qu’une bonne image vaut mieux qu’un long discours, voici donc un exemple pour illustrer ce que je viens de dire.

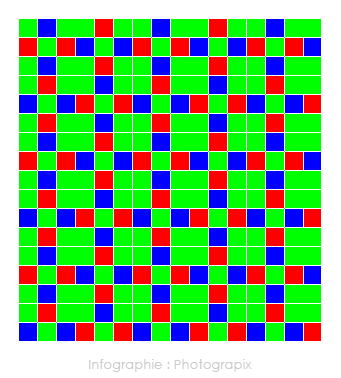

Voici donc trois images correspondant aux trois couleurs captées par les photosites.

L’image telle que vue par les photosites sensibles au rouge

L’image telle que vue par les photosites sensibles au vert

L’image telle que vue par les photosites sensibles au bleu

On combine ces trois images, ce qui permet de visualiser les données transmises par le capteur. Voilà ce que contient réellement le fichier Raw (c’est pas top hein ?). On est encore loin d’obtenir une image…

L’image après combinaison des photosites sensibles au rouge, vert et bleu

Le fameux dématriçage, appelé aussi dérawtisation ou développement, correspond donc à une interprétation des données transmises par le capteur et traitées par le processeur de votre APN ou par votre logiciel de retouche en vue de générer une image. C’est là que l’on comprend ce qu’est réellement un fichier Raw et que ce terme prend tout son sens.

Le Raw n’est pas une image. C’est un fichier qui contient des données transmises par le capteur et non interprétées. Pour qu’il devienne une image, il faut de dématricer.

Chaque fabricant d’APN ou éditeur de logiciel de traitement Raw à donc sa propre formule mathématique, son algorithme maison pour calculer les valeurs inconnues de rouge, de vert et de bleu et qui permettront d’obtenir l’image finale en couleur.

Pour aller un peu plus loin, il faut savoir que le dématriçage ne se limite pas au seul calcul des valeurs inconnues de couleurs (j’ai simplifié au maximum la manière dont fonctionne le capteur). Ce que je peux ajouter c’est que, une fois les photons capturés, il sont convertis en une impulsion électrique qui est envoyée au processeur de votre APN. Du coup, il faut aussi faire le tri des émissions électriques parasites générées par l’électronique interne de l’appareil (quel bordel ça doit être de travailler sur ces algorithmes…)

Tout ceci pour vous dire qu’il existe une infinité de possibilités d’interprétation des données contenues dans un fichier Raw. Vu qu’il existe des milliers de fichiers Raw différents (un par appareil), je vous laisse imaginer le nombre colossal d’algorithmes de développement qui existent pour interpréter ces types de fichiers. Ces algorithmes sont sans cesse améliorés, optimisés, pour répondre aux progrès technologiques.

Ces algorithmes, c’est ce qui fait la valeur ajoutée des industriels. C’est comme la recette du Coca Cola ou du kouign aman pur beurre de Douarnenez (miam !!). C’est top secret ! C’est ce qui caractérise la différence de rendu d’image entre les photos issues des différentes marques d’appareils ou développées avec différents logiciels.

Par exemple, Nikon ne fabrique pas ces propres capteurs et fait appel à Sony pour la fourniture de ces pièces. Pour autant, le rendu d’image est différent. Si ces deux marques mettent à priori les mêmes yeux (le capteur) dans leurs boitiers, ils n’ont en tous cas, pas le même cerveau (les algorithmes). C’est particulièrement visible sur les photos prises à très haute sensibilité ou la gestion du bruit et l’accentuation sont souvent gérées différemment entre les appareils.

Par contre, une image JPEG, qu’elle soit ouverte avec Photoshop, Photofiltre, ou tout autre logiciel, afffichée sur votre smartphone ou votre télévision aura toujours le même rendu. Tout simplement parce que les couleurs sont déjà codées et inscrites dans le fichier. Le JPEG, c’est une image, un fichier prêt à l’affichage. Le Raw est, comme je l’ai dit plus haut un fichier à interpréter. Voilà la véritable différence entre ces deux formats.

Je ne vais bien sur pas me risquer à expliquer dans le détail le processus de dématriçage. J’en suis bien entendu tout à fait incapable, et puis bon, est-ce vraiment utile ?

Conclusion

Voilà pourquoi de nombreux photographes ont fait le choix du format Raw à la prise de vue. Ils veulent pouvoir récupérer un fichier brut non interprété. Ce système offre de nombreux avantages :

- Ce type de fichier est non compressé et possède un potentiel de retouche très important.

- Il permet de s’affranchir du réglage de la balance des blancs à la prise de vue et de la modifier si besoin en post traitement.

- Il permet de choisir l’espace couleur dans lequel on veut travailler.

- Il permet enfin de pouvoir bénéficier des futurs algorithmes de développement proposés par les éditeurs de logiciels. Par exemple, Lightroom en est à son troisième processus de développement (2003, 2010 et 2012). A chaque fois, la qualité des images s’est bien entendu améliorée. D’ailleurs, à ce titre, peut-être que la future version de ce logiciel intégrera un nouveau processus de développement ?

Bonjour et bienvenue, moi c'est Loïc.

Quand je ne rédige pas d'articles,

Bonjour et bienvenue, moi c'est Loïc.

Quand je ne rédige pas d'articles,

Ces explications datent un peu (6 ans) mais les termes sont à peu près les mêmes. Cà fait quelques années que je fais de la photo (argentique puis numérique) en passant par Pentax puis maintenant Fuji avec l’xt4. Tout çà c’est un peu comme de passer à la machine à écrire avec la fameuse corbeille à un ordinateur qu’il soit fixe ou portable : la place des lettres sur le clavier sont au même endroit. Après, c’est comme tout on s’adapte et on apprend !

Merci pour toutes ces infos

il me restait encore quelque cheveux mais a force de me les arracher en lisant vos echanges abscons en langue

etrangere a laquelle je comprends goutte, il ne va pas m’en rester beaucoup;Il faut que je m’offre un lexique

Ceci dit bonne nuit a tous

Je vais illustrer mon propos par une expérience personnelle. J’ai commencé la photo avec ma première épouse dans les années 70/80. Elle était absolument allergique à toute forme de technique. Quand elle prenait une photo elle me demandait : « Là, j’ouvre à combien ? » Je lui répondais : « Ça dépend. Quelle profondeur de champ tu veux obtenir ? » Elle : « M’embête pas avec la technique, je n’y comprends rien. »

Elle avait à part ça incontestablement l’œil pour devenir une bonne photographe. Elle avait l’art de la composition et de l’instant décisif… mais ses photos étaient presque toutes gâchées par des défauts techniques rédhibitoires. Dommage.

Il y a aujourd’hui des appareils dits ‘point and shoot’, les smartphones en particulier. Si on veut en faire plus il faut bien en passer par la technique. Et donc les topos de Loïc sont précieux.

Nico

Tout d’abord Merci de prendre en compte mon bavardage,mais pour comprendre une langue il faut d’abord en passer par le vocabulaire la syntaxe vient apres et c’est pourquoi je parlais de lexique, mais Loic vient precisement de m’en indiquer un MERCI les artistes

Sans vouloir vous décourager, il n’y a pas que le vocabulaire, il y a la théorie elle-même, sans laquelle le vocabulaire n’a pas de sens… comme dans tout.

Bon courage.

Bonjour Roger,

Ne vous inquiétez pas, c’est du délire de passionnés de photographie pour faire croire qu’ils maîtrisent le sujet 😉

Par contre, si vous êtes à la recherche d’un lexique de la retouche photo, il y en a justement un sur ce blog.

je vais photographier en format RAW et travailler le sujet. Merci

« je vais photographier en format RAW et travailler le sujet. »

Étant donné que l’écrasante majorité des logiciels de photos affiche les fichiers RAW de toutes les grandes marques, à part quelques formats exotiques (Hasselblad par exemple), la gestion de sa collection de photos qu’ils soient RAW ou JPG est totalement transparente. Certes, on ne peut pas publier un RAW sur internet par exemple mais il suffit pour ça de faire un Exporter… en JPG, ce dont n’importe quel soft est capable.

Alors pourquoi RAW si l’on est globalement satisfait des photos brutes de décoffrage de son APN et qu’on ne fait pas de retouche systématique ? C’est que si l’on souhaite un jour améliorer tel rendu des couleurs, récupérer tel ciel un peu cramé ou telle ombre bouchée, modifier telle balance des blancs, un RAW laisse dix fois plus de latitude qu’un JPG… dans lequel il n’y a bien souvent rien à récupérer. C’est donc un investissement à long terme et qui ne coute que l’espace disque qu’il occupe. On peut donc commencer la correction tranquillement, au gré des besoins, mais sans prise de tête tout en gérant sa bibliothèque de façon transparente, et si l’on mord à la chose monter en charge graduellement.

Nico

C’est comme le Champagne, je ne l’aime que BRUT. Vive le RAW ! 🙂

Pour quelqu’un qui prend sa photo au sérieux il n’y a plus guère de raison de ne pas shooter en RAW. Dans le milieu des années 2000 c’était encore un peu galère par certains côtés. Maintenant n’importe quel visualiseur est capabable d’afficher n’importe RAW de grandes marques, du moins dans un délair raisonnable après la sortie du modèle.

Ce qui manque encore c’est un minimum de standardisation, en particulier entre logiciels de dématriçage. J’utilise DxO OpticsPro : il est le seul à pouvoir lire les fichiers sidecars qu’il génère pour stocker les modifications et d’ailleurs il ne lit pas non plus ceux des autres éditeurs comme les fichiers XMP. Je crains qu’on doive attendre encore longtemps avant qu’on puisse passer un RAW d’un logiciel à l’autre de façon transparente.

Nico

Les .dop , .xmp et autres fichiers créés par les logiciels de dématriçage restent la propriété privée des éditeurs de logiciels qui en sont à l’origine. Il est probable que cet état de fait perdure pour un bon moment. Les options de retouche étant différentes d’un logiciel à l’autre, il n’y a donc aucune chance pour que les fichiers side-cars de deux logiciels concurrents contiennent les mêmes infos et qu’ils soient donc lisibles alternativement par ces mêmes logiciels.

C’est la même chose avec le format TIFF. Bien qu’il soit un fichier ouvert (et donc universel), il ne contient pas les mêmes infos selon qu’il a été généré par Photoshop ou Affinity Photo. Tout simplement parce que les calques de réglages, les filtres et autres options de ces logiciels sont différents.

Par contre, je ne comprends pas ce que vous voulez dire quand vous dites que DxO est le seul à lire les fichiers side-cars qu’il génère. Tous les logiciels peuvent lire leurs propres fichiers,. Sinon, à quoi bon les créer ?

Oui et non. XMP a été créé par Adobe qui l’a mis dans le domaine public et il est devenu un standard de l’ISO… fort peu utilisé hormis par Adobe, hélas.

De son côté les fichiers .dop de DxO sont des fichiers texte qu’on peut ouvrir avec un simple traitement de texte où les réglages sont enregistrés en langage naturel très facilement interprétables. Je le sais, j’en ai ouvert et j’ai essayé de faire des modifications à la main, en pure perte je dois le dire 😉 . Ce que DxO ne révèle évidemment pas ce sont les algorithmes correspondant à ces instructions.

Je me suis fait mal comprendre : DxO OpticsPro lit bien entendu ses propres fichiers sidecars .dop… et heureusement, sinon qui le ferait ? Cela dit il ne lit pas les DNG qu’il génère lui-même !

De façon générale je trouve que c’est une politique à courte vue de ne pas favoriser la standardisation. Adobe tient son succès certainement en grande partie du fait qu’il a systématiquement mis ses formats dans le domaine public, le pdf en est un exemple éclatant.

Nico

Vous avez raison, j’ai été imprécis sur le standard XMP qui est bien entendu dans le domaine public.

De toute façons même si un jour, le XMP s’impose dans les dématriceurs, on ne pourra pas pour autant commencer le traitement Raw sur un logiciel et le finir sur un autre du fait des algorithmes…

On a le droit de rêver, non ? 😉

Dans un registre tout à fait différent il y a le SQL (Standard Query Language) qui définit un jeu d’instructions pour la création de bases de données, leur modification, l’entrée de données, la recherche, etc.

Chaque SGBD implémente ça avec ses propres algorithmes, crée sa propre structure de données, etc. Mais une base créée avec le soft Bidule peut être reproduite à l’identique avec le soft Trucmuche, Bidule peut envoyer des requêtes à Trucmuche pour introduire, modifier ou récupérer des données. Bon, d’accord, certains SGBD s’écartent du standard mais sur des détails.

Il me parait donc possible sur le principe que DxO OpticsPro par exemple puisse interpréter et afficher les modifications apportées à un RAW par LightRoom et vice-versa. Il faudrait bien sûr que les hommes de bonne volonté se donnent la main. J’ai bien dit qu’on avait le droit de rêver ! 😉

Il y aurait par exemple le problème de la gestion des copies virtuelles créées par DOP. Cela demanderait de s’entendre puisque le standard XMP est sous la responsabilité de l’ISO.

Nico

A 85 ans bientôt je croyais planer mais non bigre j’ai » a peu pres « tout compris j’ai dis « a peu pres « hein,et c’est bien pourquoi je ne photographie plus qu’en RAW MERCI vous êtes formidable

Merci pour ce message plein d’encourragements

Merci pour la leçon. J’ai appris quelque chose. A bientôt.

Que dire !

Bravo, et toujours avec une note d’humour.

ça, c’est l’effet Kouign Aman !!

Bravo et merci pour ces explications qui nous font pénétré au coeur de la magie de la prise de vue numérique.

Car pour moi ça reste bien de la « magie »…

Bientôt RGBW ?

On verra…